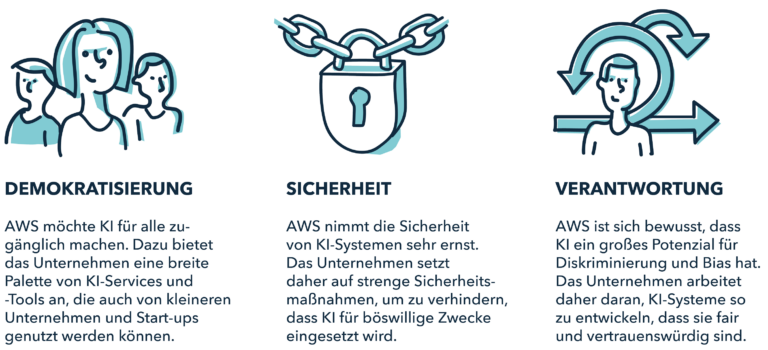

Die künstliche Intelligenz (KI) ist eine der bedeutendsten Technologien unserer Zeit. Sie hat das Potenzial, unser Leben in vielerlei Hinsicht zu verändern. Doch bei der Entwicklung und Nutzung von KI ist es wichtig, ethische Grundsätze zu beachten. Amazon Web Services (AWS) hat sich daher zu den Prinzipien der Demokratisierung, Sicherheit und Verantwortung verpflichtet.

areto AWS KI Strategie

Mit dem Begriff „Künstliche Intelligenz“ (KI) verbindet ein Großteil der Endanwender*innen heute die Generative KI, welche auf Large Language Models (LLMs) beruht. Generative KI ist aber nur ein Teilbereich von KI, diese umfasst weit mehr, so auch Machine Learning mit einer Vielfalt an Algorithmen. Eine wichtige Rolle bei der Leistungsfähigkeit von KI spielen Foundation Models (FMs). Diese werden aufwendig und kostspielig vortrainiert und greifen auf eine sehr große Menge von Trainings-Daten zurück. Dieser Prozess wird „Pre-Training“ genannt. Die FMs sind die Grundlagen für die KI-Nutzung sowohl in der „Private cloud“ wie in der „Public Cloud“.

Da zu den Trainingsdaten natürlich auch Inhalte des Internets gehören können, trainieren die Provider von Large Language Models in einem zweiten Schritt das Modell darauf, faire, balancierte, wahre und ansonsten qualitativ gute Ergebnisse zu produzieren. Die Verantwortung beginnt für Hersteller, wie für Data Scientists bereits damit, qualitativ geprüfte und für gut befundene Trainingsdaten zu verwenden.

Amazon-SageMaker-JumpStart

So funktioniert zum Beispiel Amazon-SageMaker-JumpStart mit einem proprietären Foundation-Model. Amazon: „SageMaker JumpStart stellt eine Vielzahl firmeneigener und öffentlich verfügbarer Grundlagenmodelle von verschiedenen Modellanbietern bereit. Grundlagenmodelle sind groß angelegte ML-Modelle, die Milliarden von Parametern enthalten und auf Terabytes von Text- und Bilddaten vortrainiert sind, sodass Sie eine breite Palette von Aufgaben wie die Zusammenfassung von Artikeln und die Generierung von Texten, Bildern oder Videos durchführen können. Da die Grundlagenmodelle bereits vortrainiert sind, können sie dazu beitragen, die Schulungs- und Infrastrukturkosten zu senken und die Anpassung an Ihren Anwendungsfall zu ermöglichen.“

Integrierte Algorithmen mit vortrainierten Modellen in AWS SageMaker Jumpstart. Amazon: „SageMaker JumpStart stellt Hunderte von integrierten Algorithmen mit vortrainierten Modellen aus Modell-Hubs zur Verfügung, darunter TensorFlow Hub, PyTorch Hub, HuggingFace und MxNet GluonCV. Sie können auch auf integrierte Algorithmen zugreifen, indem Sie SageMaker Python SDK verwenden. Integrierte Algorithmen decken allgemeine ML-Aufgaben ab, wie z. B. Datenklassifizierungen (Image, Text, Tabelle) und Stimmungsanalyse.“

Lösungen in AWS SageMaker Jumpstart. Amazon: „Vorgefertigte Lösungen können für gängige Anwendungsfälle verwendet werden und sind vollständig anpassbar.“

„Im Finetuning oder im weiteren Training bringt man dem Modell bei, faire gute, korrekte und ansonsten eben akzeptable, Bias-freie Antworten zu generieren. Die Anbieter verfolgen dabei unterschiedliche Strategien, wie sie ihre Modelle trainieren. Und das produziert natürlich eine Fülle von unterschiedlichen Modellen, die auf dem Markt verfügbar sind.“ erläutert Dr. Thomas Margraf, Data Science Experte bei areto.

AWS ist außerdem sehr um Demokratisierung der KI-Technologie bemüht. „Und eines der Ziele von areto ist, dass wir diese Technologie möglichst vielen Kunden zur Verfügung stellen wollen.“ so Dr. Thomas Margraf weiter. Nach dem Training und dem Finetuning kommt das Filtern der Nutzereingabe (des „Prompts“) und der Modellausgabe. Dafür gibt es entsprechende Algorithmen und Services.

„AWS bietet verschiedene KI-Services, und einer davon ist Amazon Comprehend. Kunden können diesen Dienst nutzen, um zu identifizieren, ob es sich bei einem vorliegenden Text um Text handelt, der personenbezogene Daten enthält, oder ein Text, der in irgendeiner Form Hassrede, Fake News, Verleumdung oder Volksverhetzung beinhaltet“, erläutert Thomas Herold, Technical Lead AWS bei areto.

Man könne solche Filter verwenden, die auf Basis von Machine Learning aufgebaut sind, die als Detektoren agieren oder die als Klassifikatoren agieren, um damit quasi um ein Modell herum Schranken oder Leitplanken zu bauen. „Wir machen unsere Kunden darauf aufmerksam, in diesem Bereich verantwortungsbewusst zu handeln.“ ergänzt Dr. Thomas Margraf, Data Science Experte bei areto.

Titan und Bedrock

AWS baut selbst ein LLM, das sie ‚Titan‘ nennen, das auch im Rahmen des Bedrock-Services angeboten wird. Und dieses Modell ist unter besonderer Berücksichtigung von verantwortungsvoller KI entstanden, bei der AWS dann sowohl beim Training als auch beim Hosting innerhalb des Bedrock-Services genau diese Leitplanken implementiert hat. Das heißt also, wenn Kunden etwas mit Titan auf Bedrock bauen, dann hat Titan schon eingebaute Leitplanken, die verhindern sollen, dass Titan eben schlechten oder illegitimen Content produziert. Titan gibt es in zwei Varianten: Titan Embeddings, um Texte in eine numerische Repräsentationen umzuwandeln, und Titan Text, ein LLM, das für verschiedene KI-Text-Anwendungen genutzt werden kann. Verantwortungsbewusstes Machine Learning habe AWS in Amazon SageMaker umgesetzt.

Wahlfreiheit bei den Modellen

„Unsere Kunden wollen die volle Auswahl“, so Torsten Mertens, Chief Sales Officer bei areto. „Jeder Kunde liebt die Freiheit, sich entscheiden zu können: Nehme ich das Modell A, B oder C? Das, welches am besten passt. Deswegen bieten wir sowohl im Rahmen von Amazon Bedrock als auch von AWS SageMaker-Service viele unterschiedliche Modelle an. Uns ist es ein Anliegen, GenAI unseren Kunden so einfach und kosteneffizient wie möglich zur Verfügung zu stellen, sodass sie es leicht nutzen können, ohne Infrastruktur zu verwalten und ohne sich um den Aufbau der Interfaces zu kümmern zu müssen.“

Individuelle Anpassungen

„Bei areto bieten wir den Kunden die Möglichkeit, ihre FM-Modelle auf ihre eigenen Bedürfnisse hin anzupassen. Und das mit ihren eigenen privaten Daten, die aber mit der von AWS gewohnten Sicherheit sicher behandelt werden, sodass eben kein anderer auf diese Daten zugreifen kann“, erläutert Thomas Herold.

Hier ist es wichtig auf den Unterschied zwischen öffentlichen und privaten Daten, mit denen Modelle trainiert werden, einzugehen. Wenn beispielsweise ein Pharmazeutisches Unternehmen sein LLM so fine-tunen möchte, dass es eine spezifische Marketingsprache und die hauseigenen Begriffe lernt, „so bieten wir für dieses Finetuning Kunden über AWS eine private Umgebung an, die wirklich nur für den Kunden spezifisch betrieben wird. Der gesamte Finetuning-Prozess ist technisch und organisatorisch so gestaltet und auditiert, dass wirklich nur die Kunden selbst darauf Zugriff haben.“ so Thomas Herold. Das verschaffe den Kunden die Gewissheit, dass ihre privaten Daten absolut sicher sind.

Technisch betrachtet funktioniere diese „Sandbox“ im Rahmen einer nur für den Kunden verwalteten VPC (Virtual Private Cloud). Und auf jeden Fall ist sichergestellt, dass eben die Daten des Kunden exklusiv nur für den Kunden zur Verfügung gestellt werden. Und auch das resultierende Modell ist nur für den Kunden verfügbar. „Alle Daten werden für den Transport verschlüsselt“, so Thomas Herold weiter. „Im Falle des Finetunings, also des Anpassens eines Modells, ist es so, dass die Daten beim Speichern immer verschlüsselt werden. Die Schlüssel stehen unter der alleinigen Kontrolle des Kunden, und damit ist ausgeschlossen, dass jemand anders drauf zugreifen kann.“

„GenAI ist für unsere Kunden eine große Chance, neue Funktionen hinzuzufügen“, berichtet Torsten Mertens. „Sie nehmen viel Geld in die Hand, um branchenspezifische Lösungen zu erstellen. Wir sehen sehr viele Anwendungsfälle aus unterschiedlichen Branchen, so etwa in der Automotive oder e-commerce-Branche.“

„Aber die Entwicklungen und Möglichkeiten von GenAI stehen noch ganz am Anfang, auch wir entdecken jeden Tag neue spannende Use Cases“, so Dr. Thomas Margraf abschließend.